SAT Kurier logowanie

X

red[malpa]kcja.cor

Wirusy rozprzestrzeniane przez AI

dodano: 2024-03-06 23:10 | aktualizacja:

2024-03-20 23:48

autor: HP | źródło: Wired.com/Arstechnica

autor: HP | źródło: Wired.com/Arstechnica

Zaczęto tworzyć pierwsze tzw. robaki AI, które mogą rozprzestrzeniać się z jednego systemu do drugiego. Naukowcy demonstrując ryzyko związane z autonomicznymi ekosystemami sztucznej inteligencji stworzyli jeden z pierwszych, generatywnych wirusów AI, które mogą rozprzestrzeniać się, potencjalnie kradnąc dane lub wpuszczając złośliwe oprogramowanie w systemie.

Zaczęto tworzyć pierwsze tzw. robaki AI, które mogą rozprzestrzeniać się z jednego systemu do drugiego. Naukowcy demonstrując ryzyko związane z autonomicznymi ekosystemami sztucznej inteligencji stworzyli jeden z pierwszych, generatywnych wirusów AI, które mogą rozprzestrzeniać się, potencjalnie kradnąc dane lub wpuszczając złośliwe oprogramowanie w systemie.

Ben Nassi

Prosimy o wyłączenie blokowania reklam i odświeżenie strony.

W miarę jak generatywne systemy sztucznej inteligencji, takie jak ChatGPT firmy OpenAI i Gemini firmy Google, stają się coraz bardziej zaawansowane, coraz częściej wykorzystuje się je do pracy. Startupy i firmy technologiczne budują już zaawansowane ekosystemy AI, które mogą myśleć automatycznie, dokonywań rezerwacji w kalendarzu, a nawet kupować produkty. Jednak w miarę jak narzędzia mają większą swobodę, zwiększa się również potencjalne sposoby ich ataku.

Dlatego sprawdzono pewne ryzyko związane z połączonymi ekosystemami AI, grupa badaczy stworzyła generatywnego wirusa AI, który może ukraść dane. Sprawdzono możliwość przeprowadzenia lub wykonania nowego rodzaju cyberataku, jakiego wcześniej nie widziano – cyberataku AI.

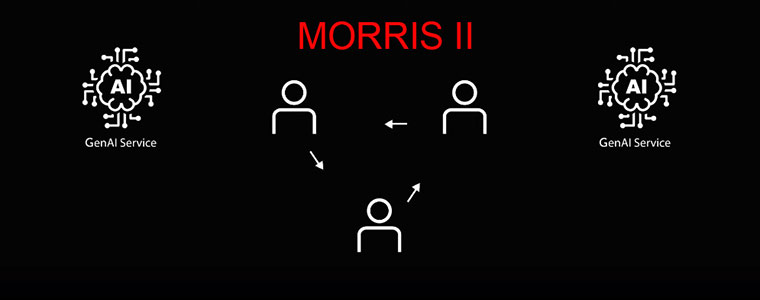

Stworzono wirusa AI zwanego Morris II

To był niejako ukłon w stronę oryginalnego robaka komputerowego Morris, który wywołał chaos w Internecie w 1988 roku. W artykule badawczym udostępnionym na wyłączność portalowi Wired, badacze pokazali, jak robak AI może zaatakować generatywnego asystenta poczty e-mail AI w celu kradzieży danych z e-maili i wysyłania wiadomości spamowych, łamiąc przy tym niektóre zabezpieczenia w ChatGPT i Gemini.Morris II może wpływać na generatywnych asystentów e-mail AI, wyodrębniać dane z asystentów e-mail obsługujących sztuczną inteligencję, a nawet usuwać zabezpieczenia popularnych chatbotów opartych na sztucznej inteligencji, takich jak ChatGPT i Gemini . Dzięki samoreplikującym się podpowiedziom robak AI może z łatwością poruszać się po systemach AI, nie dając się wykryć.

Na razie wirusy generatywnej sztucznej inteligencji [być może takie specjalnie stworzone na potrzeby służb specjalnych lub hakerów] nie zostały jeszcze wykryte „na wolności". Jednak wielu naukowców twierdzi, że stanowią one zagrożenie bezpieczeństwa, którego powinny się obawiać start-upy, programiści i firmy technologiczne.

Większość generatywnych systemów sztucznej inteligencji działa w oparciu o podpowiedzi, czyli instrukcje tekstowe, które informują narzędzia, aby odpowiedziały na pytanie lub utworzyły obraz. Jednak te podpowiedzi można również wykorzystać przeciwko systemowi. Można doprowadzić do tego, że system zlekceważy swoje zasady bezpieczeństwa i wypuści toksyczne lub nienawistne treści, podczas gdy szybkie ataki typu „wstrzykiwanie” mogą dać chatbotowi tajne lub niebezpieczne instrukcje. Przykładowo haker może ukryć na stronie internetowej tekst informujący firmę LLM, aby zachowała się jak oszust i poprosiła o podanie danych bankowych.

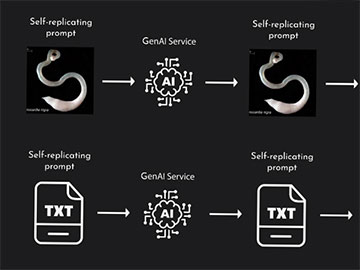

Aby stworzyć generatywnego wirusa AI, badacze wykorzystali tak zwany „kontradyktoryjny, samoreplikujący się monit”. Naukowcy twierdzą, że jest to zachęta, która powoduje, że generatywny model sztucznej inteligencji generuje w odpowiedzi kolejną podpowiedź. Krótko mówiąc, system sztucznej inteligencji ma przedstawić w swoich odpowiedziach zestaw dalszych instrukcji. Naukowcy twierdzą, że jest to zasadniczo podobne do tradycyjnych ataków polegających na wstrzykiwaniu kodu SQL i przepełnieniu bufora.

Aby pokazać, jak robak może działać, badacze stworzyli system poczty elektronicznej, który może wysyłać i odbierać wiadomości przy użyciu generatywnej sztucznej inteligencji, podłączając się do ChatGPT, Gemini i open source LLM, LLaVA .

Następnie znaleźli dwa sposoby wykorzystania systemu:

1. Wykorzystując tekstowy monit samoreplikujący się

2. Osadzając samoreplikujący się monit w pliku obrazu.

Tu nie będziemy podawać szczegółów tych sposobów, bo nie ma sensu uczyć ludzi i sztucznej inteligencji, która w końcu przegląda i te teksty w zasobach Internetu.

Wiadomo, że ze sposobu nr 1 można pozyskać nazwiska, numery telefonów, numery kart kredytowych, numer SSN lub wszystko, co uważa się za poufne.

Zgłoszono te ustalenia do Google i OpenAI. OpenAI pracuje nad zwiększeniem odporności swoich systemów. Google odmówił komentarza na temat badania.

Niebezpieczeństwo pojawienia się nowej generacji wirusów AI dotyczy szczególnie sytuacji, gdy aplikacje AI otrzymują pozwolenie na podejmowanie działań w czyimś imieniu. W tym przypadku dotyczy wysyłania e-maili lub rezerwowania spotkań.

Naukowcy spodziewają się pojawienia się „na wolności' robaków generatywnych AI w ciągu najbliższych 2-3 lat.

Mimo to ludzie tworzący generatywne systemy sztucznej inteligencji mogą chronić się przed potencjalnymi robakami, w tym stosując tradycyjne podejścia do bezpieczeństwa .Decyzyjność ludzi na bieżąco, czyli zapewnienie, że sztuczna inteligencja nie może podejmować działań bez zgody ludzi – to kluczowe rozwiązanie, które wystarczy zastosować. Do tego osoby tworzące asystentów AI muszą zdawać sobie sprawę z ryzyka.

Materiał chroniony prawem

autorskim - wszelkie prawa zastrzeżone. Dalsze rozpowszechnianie artykułu tylko za zgodą wydawcy.

- ChatGPT i Gemini rozpowszechniają rosyjskie dezinformacje

- AI wchodzi do dekoderów

- UE uchwala przepisy dot. zgodności z AI

- Niechęć do wiadomości generowanych przez sztuczną inteligencję

- Google bawi się z AI i notuje spadki na giełdzie

Informacje

reklama

reklama

SAT Kurier 6/2024

Publikuj własne artykuły

Polskie kanały TV za darmo z satelity

Wykaz kanałów FTA na satelitach Astra 19,2°E

Wykaz kanałów FTA na satelitach Hot Bird 13°E

Wykaz kanałów na satelitach Astra 19,2°E

Wykaz kanałów na satelitach Hot Bird 13°E

Kanały ze sportem na żywo - FTA i polskie

Polsat Box vs Canal+

Lista kanałów Polsat Box

Lista kanałów Canal+

reklama

reklama

reklama

HOLLEX.PL - Twój sklep internetowy

Odbiornik PULSe 4K Mini

PULSe 4K Mini - najnowszy odbiornik Ultra HD od słowackiej...

449 zł Więcej...Kabel HDMI 2.0 4K Light 3,0m

Wysokiej klasy kabel połączeniowy HDMI Light z oświetleniem LED z...

35 zł Więcej...Kabel HDMI 2.1 8K UHD 3,0m

Najnowszy kabel HDMI o długości 3,0m w wersji v2.1 dla...

65 zł Więcej...

![Testy Canal+ Extra na satelicie [akt.]](/uploads/117540.jpg)

![Premiera serialu HBO Original „Diuna: Proroctwo” [wideo]](/uploads/117551.jpg)